您现在的位置:返回首页

有关新沂地铁二十二号线多久才能通车?谁能回复一下?

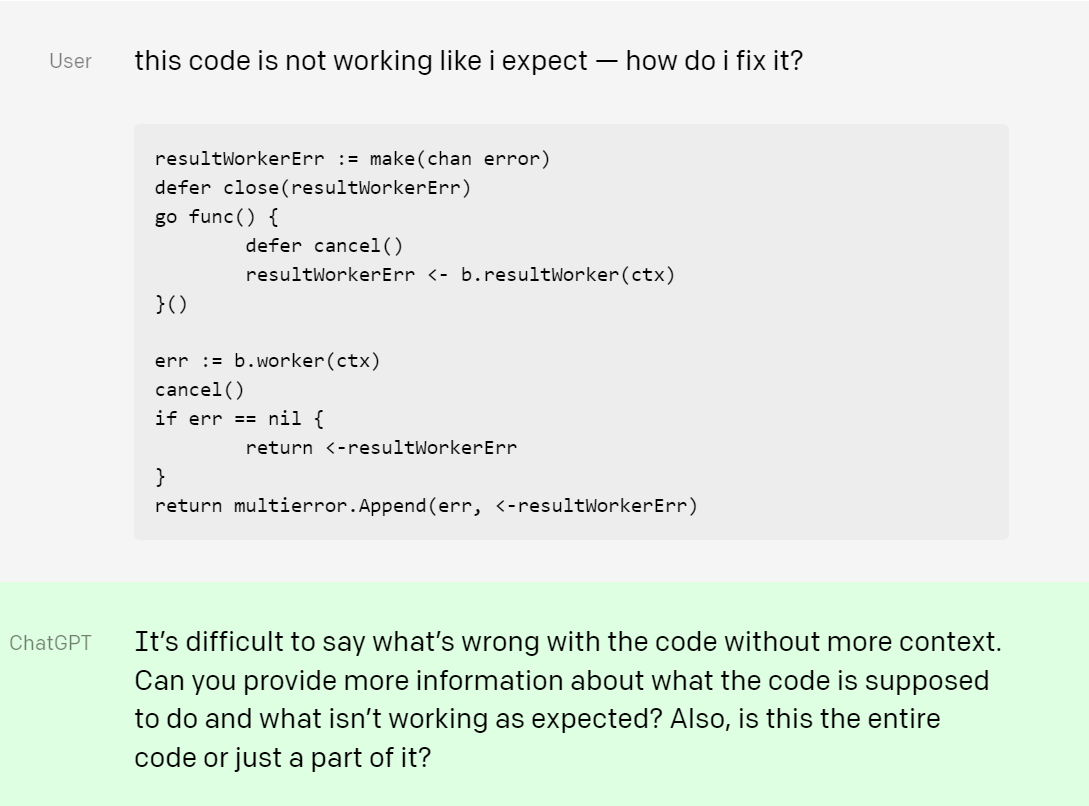

ChatGPT大热,不少人已经用它来写作业、写论文、写演讲稿……ChatGPT快速高效的内容创作能力也让不少人惊呼,内容创作是不是要被AI取代了?

然而,乐此不疲地使用这项新技术生成内容的同时,我们应该思考一个问题:ChatGPT生成的内容是否有着作权?其“创作”的版权又该归谁? 这项技术的使用真的安全可靠吗?

对于上述问题,2月11日,《每日经济新闻》记者对话奋迅律师事务所(贝克·麦坚时联营律所)合伙人周整、泰和泰律师事务所首席合伙人程守太、安杰世泽律师事务所合伙人于雯竹以及上海明伦律师事务所律师王智斌,进行了探讨。

在某销售ChatGPT账号的淘宝商家的用户评价中,《每日经济新闻》记者发现,有购买者的诉求是使用ChatGPT写论文。2月9日,每经刊发的报道也显示,国内高校已经有学生开始使用ChatGPT写论文。

今年1月初,美国北密歇根大学的学生利用ChatGPT写作论文的事件还历历在目,ChatGPT给美国教育体系带来的冲击显而易见:许多大学正在对课堂进行大规模的调整,纽约和西雅图等学区已禁止在其设备和网络中使用ChatGPT。

随着越来越多的人使用该技术来生成内容,一个问题是,ChatGPT生成的内容会产生着作权吗?

安杰世泽律师事务所合伙人于雯竹向每经记者表示,在中国,根据相关判决,一个作品享有着作权的前提之一是由自然人创作。“因此,如果ChatGPT生成内容的创作过程中表现出了自然人作者(即ChatGPT的用户)的个性化判断、取舍、风格等写作安排,且ChatGPT生成内容满足了着作权法的其他要求(比如独创性),则ChatGPT生成的该内容可认为是着作权法意义上的作品,享有着作权。”

不过,奋迅律师事务所合伙人周整则告诉记者,关于AI创作的作品是否具有独创性,目前尚无定论。他给出了两个案例,“我国司法实践中存在不同的观点。在腾讯诉盈讯案中,腾讯利用智能写作Dreamwriter创作的文章被盈讯发布在互联网上,深圳南山区法院认可了该文章着作权人为腾讯。”

“但在菲林律所诉百度公司案中,菲林利用某家智能可视化软件自动生成报告,而北京互联网法院拒绝承认菲林对该报告享有着作权,并称在自动生成报告中简单的数据选择和图像选择并不足以具有独创性,”他说道。

另一个问题是,ChatGPT生成的论文若有着作权,应当属于谁?对于这一点,律师间也有一些不同的看法。

周整认为,可以参考腾讯案中的观点,即AI软件生产的作品的着作权应归属于该软件的所有者。他表示,“因为ChatGPT生成内容的原理是参考现有互联网内容并按照用户指令生成解答,而ChatGPT这个软件本身就是作品,具有着作权,我们可以认为其形成解答内容的过程是通过内部的无数模板完成的,这些模板本身也可能构成具有独创性的表达,受到着作权保护。”

在于雯竹看来,根据OpenAI的使用条款中规定,在用户遵守相关条款和法律法规的前提下,OpenAI 将其对ChatGPT 所输出内容的所有权利、所有权和利益转让给用户,这其中就包括了着作权。“当然,前提是ChatGPT生成的内容被认定为‘作品’,享有着作权,”她补充说道。

泰和泰律师事务所首席合伙人程守太告诉记者,ChatGPT属于人工智能,其并非属于我国着作权法意义上的作者,其生成的内容是否享有着作权、由谁享有着作权还存在争议。

“一般来说,AI生成的内容具有独创性并能以一定形式表现的即享有着作权,”程守太说道,“但根据ChatGPT的服务条款可知,只有该聊天软件独有的‘输出内容’才发生着作权的转让,该规定在一定程度上保护了ChatGPT,但对于用户来说增加了极大的不确定性。在后续传播过程中,也会出现权利链条不清晰,权利人不清晰的问题。”

不过,对于利用ChatGPT写作论文的情况,前述三位律师都认为,有较大可能会出现侵权问题。

“因为AI生成内容的基础是海量分析互联网上的现有信息和内容,其中当然包括受到着作权法保护的作品。基于他人作品,并通过模仿他人表达方式生成的结果,具有侵权风险的可能性较大。但随着人工智能技术的发展,可能以后会绕开跟现有作品同样的表达,从而规避侵害着作权的风险,”周整告诉《每日经济新闻》记者。

ChatGPT的强大令许多人啧啧称奇,关于其生成内容的安全性也开始引发思考。

第一是内容准确性问题。“ChatGPT生成内容的准确性无法保障。用户随手将网上看到的内容、观点上传到平台,ChatGPT在用户海量信息提取的过程中自主学习进化,此种数据来源不够真实准确,”程守太告诉记者,“ChatGP也存在虚假信息回复问题,此种虚假回复应用在商业中会造成严重后果,甚至有法律风险。”

鉴于此,ChatGPT极容易被虚假信息误导。据《纽约时报》2月8日报道,研究人员测试了ChatGPT在被问及充满阴谋论和虚假叙述的问题后会写些什么,结果非常令人不安。NewsGuard的联合首席执行官Gordon Crovitz表示:“该工具能够以超乎想象的规模生成虚假信息,而且频率很高,它可能将成为互联网有史以来最强大的错误信息传播工具。”

第二是容易被不法者利用的问题。上海明伦律师事务所律师王智斌告诉每经记者,“问题的另一面是,使用者失去了自行查阅不同搜索结果并自行判断的机会。从这个角度而言,ChatGPT更容易实现信息和答案的垄断,也更容易成为舆情的操纵工具,”他说道。

据《纽约时报》,提供网络威胁情报的组织Check Point Research发现,网络犯罪分子已经在尝试使用ChatGPT创建恶意软件。该组织工程主管Mark Ostrowski表示,虽然黑客攻击通常需要高水平的编程知识,但ChatGPT为新手程序员提供了帮助。

第三还可能存在数据安全的问题。程守太表示,“ChatGPT将网络交互获取的数据转化为自己的知识图谱或者存入知识库,并上传至相应运营公司数据平台。其数据获取途径和获取方式是否合法合规,数据的合理使用范围、使用边界问题、恶意利用问题,还需结合不同地区法律具体分析。”

同时,他认为,“用户和ChatGPT交互的过程中,ChatGPT获取大量用户或者业务相关数据,若用户在聊天时输入了涉密信息,ChatGpt会识别信息并存在后台,可能会导致侵犯个人信息,泄露个人隐私、商业秘密以及国家机密。”

第四需要注意价值导向的问题。在程守太看来,ChatGPT生产的内容是基于全网的数据和算法分析处理所得到的,与我国主流媒体的话语体系存在一些不兼容之处,尤其是互联网企业、媒体使用时更需要考虑背后价值导向。

如需转载请与《每日经济新闻》报社联系。未经《每日经济新闻》报社授权,严禁转载或镜像,违者必究。

特别提醒:如果我们使用了您的图片,请作者与本站联系索取稿酬。如您不希望作品出现在本站,可联系我们要求撤下您的作品。

几乎人人都用过!这个网红表情包,不能随便用了?有公司使用七张,被判赔4650元…

中国银河给予计算机行业推荐评级:聊天机器人顶流ChatGPT,开启自然语言处理领域新篇章

40个案例彰显区域典范 2022年成都市优化营商环境建设案例评选结果出炉

专访蓝天救援队总指挥张勇:很遗憾没能早点赶到土耳其灾区,即使只有1%的希望也要坚持救人

德国、奥地利宣布在土耳其暂停救灾!江苏一女子被埋25小时后获救,土官员:两次强震相当于500颗原子弹爆炸

推荐内容

MORE- (10-26) 直播带货如何变“一时火”为“一直

- (09-23) 迸发青春力量诠释向上朝气

- (12-11) 柘城地铁七号线什么时候建?希望回

- (11-28) 成都市地铁三十四号线沿途站点有哪

- (12-02) 关于昌宁地铁三十九号线沿途站点有

- (08-09) 网购院内制剂是“神药”还是骗局?

- (11-19) 关于南京地铁四十九号线票价是多少

- (11-10) 八阿哥是谁演的为什么会上热搜?

- (12-04) 关于宜君地铁32号线换乘方案,没有

- (05-29) 冀j是哪里的车牌号(冀J是哪里的车

- (07-29) 郑州地铁12号线号线米

- (11-19) 杭州地铁四十一号线线路图高清有谁

- (01-25) 平利地铁32号线什么时候通车?必须

- (12-09) 有关明水地铁8号线什么时候开工?解

- (08-28) 书亦烧仙草(书亦烧仙草老板创始人

- (12-06) 关于吉安地铁24号线换乘方案,谁能

- (01-23) 中江地铁7号线运营时间表,你清楚吗

- (11-06) 关于卓有成效的近义词这样理解正确

- (01-23) 关于呼兰地铁十四号线站点有哪些?

- (02-10) 关于施甸地铁35号线站点有哪些?有

栏目热点

更多>>- (22-12-02) 有关千阳地铁25号线票价是多少?有

- (22-12-17) 共和地铁18号线最新规划图,谁能解

- (22-06-26) 深入推动川渝全方位合作奋力书写成

- (22-11-17) 安庆地铁五号线最新路线图解答一下

- (22-09-12) 卫生间到底要不要做干湿分离?

- (22-11-19) 宁德地铁十号线什么时候开工?希望

- (22-10-07) 中国女队轻取葡萄牙队晋级四强

- (22-11-08) 东莞地铁42号线还要多久才能通车?

- (22-08-07) 全市市场主体净增全省“双第一”

- (23-01-28) 关于讷河地铁三十六号线有哪些站点

- (22-12-15) 关于安化地铁四十四号线运营时间表

- (23-01-01) 赣州地铁三十二号线什么时候通车?

- (22-05-23) 3-23-0欧洲一夜诞生2大冠军:曼城

- (22-12-24) 轮台地铁三十六号线什么时候通车?

- (22-11-24) 岳阳地铁十号线换乘方案能解答下吗

- (23-01-06) 关于牟定地铁二十四号线票价是多少

- (22-11-22) 关于沈阳地铁十六号线换乘方案必须

- (23-02-11) 泸县地铁33号线最新线路图,有没有

- (22-11-01) 前三季度全市经济运行恢复向好

- (23-01-12) 平泉地铁3号线最新规划图,你清楚吗